Vorweg

Dies ist kein Howto bis auf den letzten Befehl herunter. Deshalb werde ich ab und zu andere Sachen verlinken statt selbst in ermüdender Weise alles noch mal aufzuschreiben. Trotzdem lasst es mich in den Kommentaren wissen, falls was Wichtiges fehlt, viel zu kurz dargestellt wurde oder falsch/veraltet ist. Danke!

Warum FreeBSD – ZFS – Netatalk? Ich bin Macfan seit geraumer Zeit, alle meine nicht-Server sind seit langem Macs, Windows und Linux spielen bei mir nur eine marginale Rolle. Netatalk kann das von Apple entworfene Apple Filing Protocol (AFP) und kann sich einem Mac als Time Machine Server ausgeben. Es ist also also der Fileserver der Wahl. Mit Mavericks (OS X 10.9) hat Apple SMB 2 Support eingebaut, wir werden also in Zukunft wahrscheinlich Samba haben wollen, besonders, wenn das dann Time Machine kann, aber momentan ist da der Status noch unklar. Wenn es soweit ist werde ich mich auf jeden Fall hier und bei der Freak Show dazu äußern.

Hardware

Bei dieser Updaterunde des Homeservers wollte ich mich nicht mehr mit den maximal 4 GB RAM der Atomboards begnügen. Das liegt vor allem daran, dass ZFS richtig viel Speicher haben will, die CPU-Performance der Atom Prozessoren würde dagegen dicke reichen. Ich habe mich also nach was besserem umgeschaut. Hängen geblieben bin ich beim Sockel 1150 und dem H87 Chipsatz im Allgemeinen und beim Gigabyte H87M-D3H im Besonderen. Mit 32 GB RAM Maximalausbau und 6 onboard SATAports kann man schon was anfangen. Dazu den ab Werk heruntergetakteten Core i3 4130T von Intel in der Boxed Variante. Ich hatte noch nie einen Prozessor selber gesteckt, aber Jahrzehnte der selbermachwütigen Idioten haben ganz offensichtlich ihre Spuren hinterlassen. Ich hätte Schwierigkeiten gehabt absichtlich was falsch zu machen. Was ich aber falsch gemacht habe ist die Motherboardgröße. Es gibt einen Unterschied zwischen mini-ITX und micro-ATX. Der ist an der kritischen Stelle meines bisherigen Gehäuses etwa 2 1/2 cm groß. Also musste ein neues Gehäuse her. Ich habe das Lian Li PC-V358 Micro-ATX Cube in schwarz gewählt, denn es versprach in meinen Schubkastenschrank zu passen. Gut, wie sich herausgestellt hat, nur mit abgeschraubten Füßen und einem abgewinkelten Kaltgerätestecker, aber hey…!

FreeBSD

FreeBSD 10 ist frisch released, da habe ich genau das heruntergeladen und per dd auf einen USB-Stick gepackt. Beim Booten dann die erste positive Überraschung:

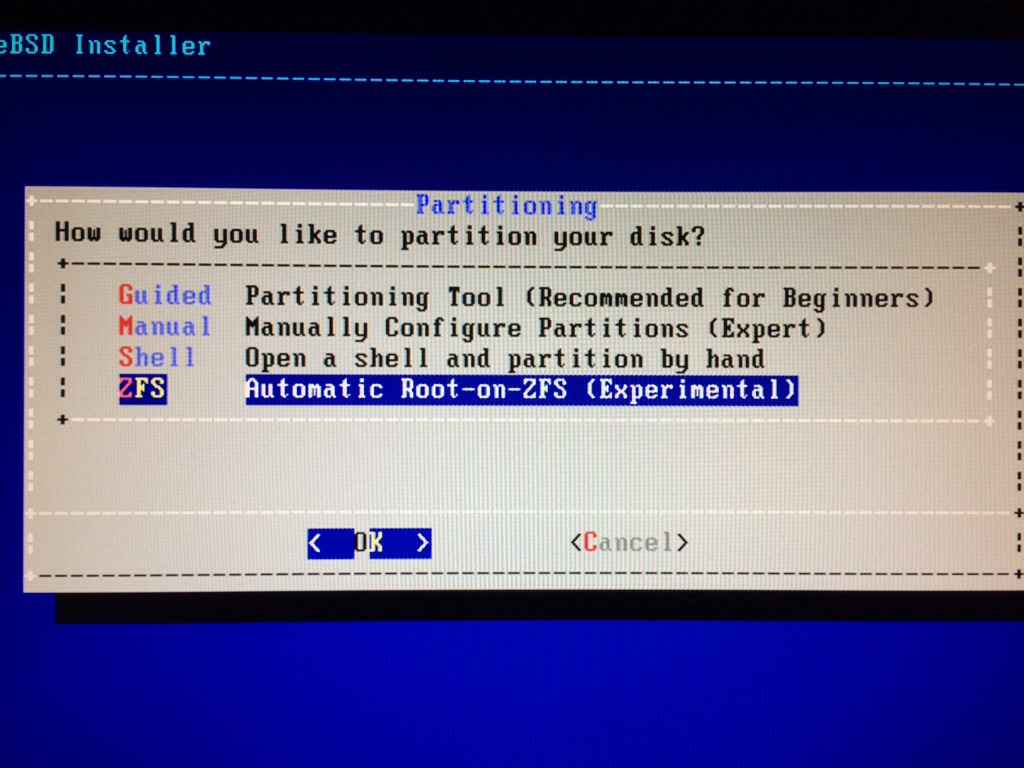

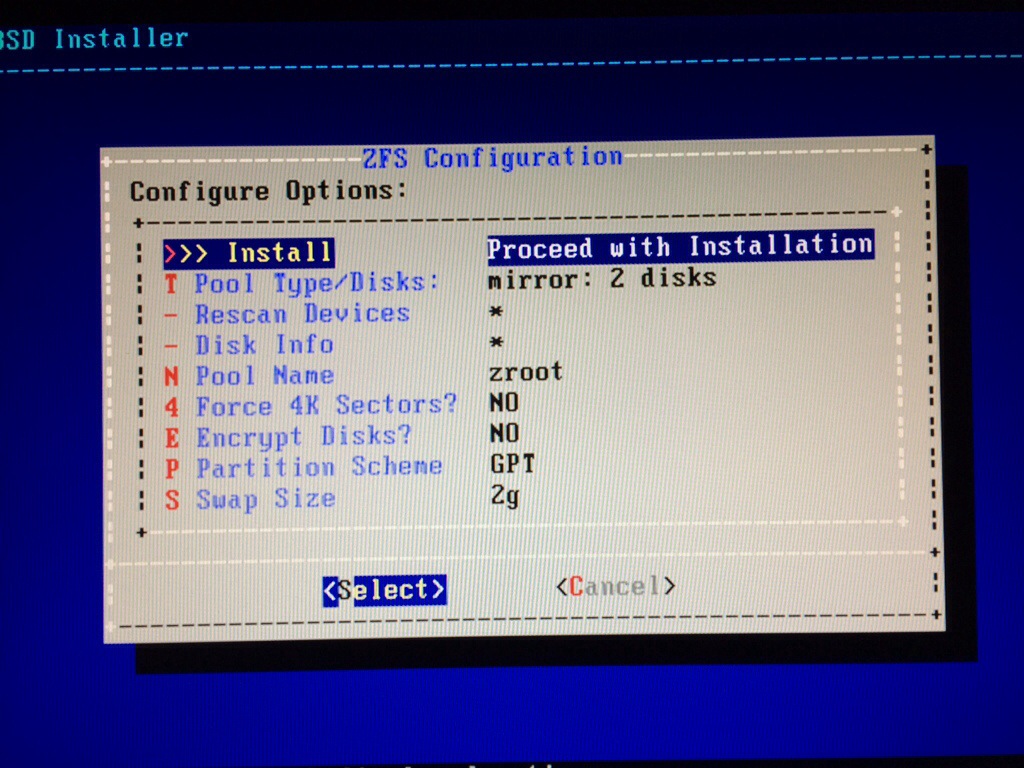

Der (seit FreeBSD 9 neue) Installer kann jetzt Root-on-ZFS installieren! Das war vorher per Hand doch sehr mühsam. Steht zwar „Experimental“ dran, hat in meinem Fall aber gut funktioniert. Ich dachte ich probier’s mal mit zwei Platten im Mirror:

Der Installer tut genau das Richtige und bietet auch keine unnützen Optionen an. Mit dem Kommando gpart show kann man sich anschauen, wie die beteiligten Laufwerke partitioniert worden sind:

root@server:~ # gpart show

=> 34 976773101 ada3 GPT (466G)

34 6 - free - (3.0K)

40 1024 1 freebsd-boot (512K)

1064 41943040 2 freebsd-swap (20G)

41944104 934829024 3 freebsd-zfs (446G)

976773128 7 - free - (3.5K)

=> 34 976773101 ada6 GPT (466G)

34 6 - free - (3.0K)

40 1024 1 freebsd-boot (512K)

1064 41943040 2 freebsd-swap (20G)

41944104 934829024 3 freebsd-zfs (446G)

976773128 7 - free - (3.5K)

Also genau wie man es haben will. Auch die angelegten ZFS Filesysteme sehen sehr vernünftig aus:

root@server:~ # zfs list

NAME USED AVAIL REFER MOUNTPOINT

zroot 5.14G 432G 144K none

zroot/ROOT 1.81G 432G 144K none

zroot/ROOT/default 1.81G 432G 1.32G /

zroot/tmp 560K 432G 176K /tmp

zroot/usr 2.79G 432G 144K /usr

zroot/usr/home 272K 432G 184K /usr/home

zroot/usr/ports 2.79G 432G 1.96G /usr/ports

zroot/usr/src 144K 432G 144K /usr/src

zroot/var 542M 432G 518M /var

zroot/var/crash 148K 432G 148K /var/crash

zroot/var/log 728K 432G 356K /var/log

zroot/var/mail 232K 432G 144K /var/mail

zroot/var/tmp 360K 432G 152K /var/tmp

Nun sollte man bei dem Pool den Failmode auf continue umschalten, sonst bleibt er beim Booten hängen, wenn etwas faul ist: zpool set failmode=continue zroot

Ports

Damit wir überhaupt richtig loslegen können brauchen wir eine aktuelle Portscollection. Also los:

root@server:~ # portsnap fetch ; portsnap extractDas kann jetzt dauern, aber es lohnt sich! Um die Ports später auf dem neusten Stand zu halten, benutze ich immer portupgrade also:

root@server:~ # portsnap fetch ; portsnap update ; portupgrade -aSSH

SSH ohne Passwort sondern mit Schlüssel. Einfach machen, und man ist vor den Skriptkiddies wieder ein Tick sicherer.

ZFS

Zu ZFS muss man ja an sich nicht viel sagen. Wer sich die Mühe macht FreeBSD zu installieren tut es in der Regel um von den Vorteilen von ZFS zu profitieren. Wer noch nicht überzeugt ist, schaue sich folgenden Output an:

root@server:~ # zpool status

pool: zroot

state: DEGRADED

status: One or more devices are faulted in response to persistent errors.

Sufficient replicas exist for the pool to continue functioning in a

degraded state.

action: Replace the faulted device, or use 'zpool clear' to mark the device

repaired.

scan: resilvered 20.7M in 0h0m with 0 errors on Sun Dec 22 20:02:57 2013

config:

NAME STATE READ WRITE CKSUM

zroot DEGRADED 0 0 0

mirror-0 DEGRADED 0 0 0

diskid/DISK-1240000000000464p2 ONLINE 0 0 0

diskid/DISK-4C532000000319101264p2 FAULTED 0 94 0 too many errors

errors: No known data errors

Ich hatte testweise FreeBSD auf zwei USB-Sticks installiert und der eine ist offensichtlich direkt gestorben. Hey, der war nagelneu! Aber kein ernstes Problem wenn man von einem ZFS-Mirror bootet, woanders würde man von vorne anfangen. Übrigens hat es sich ausgezahlt, Datenträger von verschiedenen Herstellern zu beziehen. Gilt auch für Festplatten! Ich würde schwer davon abraten mehrere baugleiche Platten vom gleichen Hersteller zu beziehen, am Besten noch aus der gleichen Charge… Keine gute Idee!

Den Datenpool habe ich mit 6 Platten und Raidz2 angelegt. Beim ersten Versuch hat ZFS gemecktert, dass eine Platte 4k-Sektoren benutzt und die Performance leiden würde. Wem das auch passiert, hier entlang: Pool anlegen mit Festplatten die intern 4K-Sektoren benutzen.

Kleiner Tip: Ich habe unter FreeBSD ganz normal einen User angelegt und ihm dann auf dem Datenpool ein eigenes ZFS-Dateisystem kreiert und es mit zfs set mountpoint=/usr/home/... an die Stelle gelegt, wo es auf dem Root-Volume angelegt wurde. So erspart man sich das Konfigurieren des Useraccounts. Und Dank ZFS muss man auch nicht in der /etc/fstab herummurksen um etwas irgendwo hin zu mounten.

Netatalk

Ein zentraler Sinn der ganzen Übung ist, wie ja bereits erwähnt, dass ich mein Time Machine Backup auf den Server machen will und dazu braucht er Netatalk. Ich habe mich gleich auf Netatalk 3.1 gestürzt. Man installiert dazu den Netatalk 3 port in /usr/ports/net/netatalk3

cd /usr/ports/net/netatalk3

make installBei der Installation hat man die Wahl zwischen Avahi und dem Apple mDNSResponder als Bonjour-Provider. Ich habe Avahi gewählt, aber Vorsicht, da hängt ein ganzer Rattenschwanz an Abhängigkeiten dran und wenn man nicht aufpasst bekommt man auch noch einen X-Server installiert.

In /etc/rc.conf muss man einen ganzen Sack Services starten sonst funktioniert das alles nicht:

dbus_enable="YES"

avahi_daemon_enable="YES"

netatalk_enable="YES"

cnid_metad_enable="YES"

afpd_enable="YES"Als nächstes kreiert man das File /usr/local/etc/avahi/services/afpd.service und tut in etwa den folgenden XML-Code hinein:

<?xml version="1.0" standalone="no"?>

<!DOCTYPE service-group SYSTEM "avahi-service.dtd">

<service-group>

<name replace-wildcards="yes">Mein Server</name>

<service>

<type>_afpovertcp._tcp</type>

<port>548</port>

</service>

<service>

<type>_device-info._tcp</type>

<port>0</port>

<txt-record>model=Xserve</txt-record>

</service>

<service>

<type>_adisk._tcp</type>

<port>9</port>

<txt-record>sys=waMA=xx:xx:xx:xx:xx:xx,adVF=0x100</txt-record>

</service>

</service-group>Avahi annonciert mit dieser Datei einen Fileserver namens Mein Server. Wichtig ist, dass man die MAC-Adress seiner Netwerkkarte dort einfügt wo im Beispiel xx:xx:xx:xx:xx:xx steht. Im Netz findet man noch weitere Anleitungen, in denen die Volumes mit Hilfe von <txt-record> Tags konfiguriert werden, aber Netatalk 3 bekommt das auch ohne hin.

Zum Schluss brauchen wir noch eine /usr/local/etc/afp.conf damit Netatalk weiß, was es tun soll. Ich schmeiße mal meine (leicht zensierte) afp.conf in die Runde:

;

; Netatalk 3.x configuration file

;

[Global]

; Global server settings

hostname = server

;login message = "Welcome"

mimic model = Xserve

zeroconf = yes

uam list = uams_guest.so uams_dhx.so uams_dhx2.so

guest account = nobody

[Time Server]

path = /TimeServer

valid users = roddi

time machine = yes

[Homes]

basedir regex = /usr/home

valid users = roddi

[Server]

path = /server

valid users = roddi

Fertig

So das war es erstmal. Wenn es Anregungen, Korrekturen oder so gibt, immer her damit. Ich hoffe der Artikel ist eine Hilfe für jeden, der es mit FreeBSD mal versuchen möchte. In diesen Sinne: Viel Spaß am Gerät!

— UPDATE —

FreeNAS

Ich wurde von diversen Seite auf FreeNAS hingewiesen worden und Ihr habt recht. Wem das hier zu viel Umstand ist, der sollte ein Blick auf FreeNAS werfen. Da bekommt man FreeBSD – ZFS – Netatalk fertig verpackt mit Webconfigurationsoberfläche auf einem USB-Stick.

NAS4Free

Außerdem kam noch der Hinweis auf NAS4Free rein. Dazu kann ich aber nichts sagen.

Hallo,

guter Artikel, aber einen Vorschläge hätte ich noch :).

Anstatt „portsnap fetch ; portsnap (extract|update)“ reich auch „portsnap fetch (extract|update)“.

Dann noch eine Frage, was für einen Datendurchsatz erreichst du mit Netatalk3 über GBit? Speziell beim TimeMachine Backup. Bei mir ist das extrem langsam.

Danke für den portsnap Tipp.

In Sachen Durchsatz kann ich noch nicht so viel sagen, aber gemessen an dem bisherigen Feedback schreit das nach einem eigenen Artikel.

Hallo,

danke für den ausführlichen Artikel. Alternativ kann ich noch OmniOS in Verbindung mit napp-it empfehlen. Damit kriege ich mein GBit-Interface über AFP nahezu ausgelastet. Das habe ich mit FreeBSD bei weitem nicht geschafft.

Viele Grüße

Christian

Danke für deine Ausführungen. Ein ähnlichen konfigurations Marathon habe ich mit Debian letztens durchgespielt. Auf einer anderen Kiste habe ich mich dann für FreeNas 9.2 entschieden und war sehr angetahn vom Web Interface und dessen Möglichkeit mit ein paar Mausklicks ein ZFS Pool einzurichten. Finde ist eine Empfehlung wert für Personen die nicht ganz so fit mit der Comman Line sind.

Ja, FreeNAS habe ich testweise im Betrieb gehabt und kann es empfehlen. Aus irgendeinem Grund macht FreeNAS aber kein ordentliches Bonjour/ZeroConf.

Hallo Roddi,

vielen Dank für den Artikel. Als völliger Neuling in Sachen FreeBSD mit ZFS würde mich die Hardware-Konfiguration interessieren. Mainboard und Prozessor wurden bereits im Artikel erwähnt.

Welche Kapazität haben Deine 6 Platten und wieviel Arbeitsspeicher hast Du spendiert?

Viele Grüße

Thomas

Die Platten sind (noch) eine bunte Mischung von Platten, die ich noch rumliegen hatte, die kleinste 750G. Ich habe momentan 16G RAM drin (2×8), kann aber auf 32G aufstocken (nochmal 2×8), falls nötig.

Kannst Du bitte noch schreiben welches Netzteil sinnvoll ist?

Klar, am besten eines, das genug Power hat um den Server zu betreiben, aber nicht zu viel, weil der Wirkungsgrad nur endlich ist und jedes fehlende Prozent in Wärme umgesetzt wird. Ich habe es erlebt, dass der Server nicht zuverlässig hochkam, weil die hochdrehenden Platten einen Spike im Stromverbrauch erzeugt haben.

Will heißen, ich habe auch keine Patentlösung dafür. Im neuen Server habe ich ein kleineres eingebaut, als im Vorgänger und bis jetzt fahre ich gut damit.

Hi roddi,

Der Artikel hat auf jeden fall daseinsberechtigung. Weil machmal soll ja so eine kiste noch mehr machen als nur NAS und netatalk. Ich überlege seit einiger zeit meinen homeserver von debian auf freebsd umzubauen. Der Artikel hier löst wieder eins von vielen teilproblemen und hilft bei der Entscheidung. Also danke dafür! 🙂

Beste Grüße!

Für alle FreeBSD 10-Benutzer: avahi-daemon – enthalten im Port avahi-app – ist derzeit defekt und terminiert mit Signal 11/Segmentation fault.

Danke für den Hinweis!

Solution:

add

--disable-stack-protectortoCONFIGURE_ARGS?=in/usr/ports/net/avahi-app/Makefile.Kudos to http://lists.freebsd.org/pipermail/freebsd-ports/2014-January/089413.html.

Danke für den Hinweis, obwohl „disable stack protection“ schon recht scary klingt für eine Netzwerkkomponente.

Der war vorher (ab FreeBSD 8) auch nur für base aktiv:

(aus: http://www.freebsd.org/releases/8.0R/relnotes.html)

Aber grundsätzlich möchte man dies natürlich für so viele Programme wie möglich aktiviert haben, und – genau – insbesondere für „netzexponierte“ Dienste.

So, in ports ist

avahi-app-0.6.31_1verfügbar, die behebt (durch o.g. Flag) den Segmentation Fault.Wow, Dein Werk?

Mal ne frage an die ZFS Profis.

Die Checkssums sind doch im RAM gespeichert, oder?

was passiert denn wenn in einem non-ECC Ram ein bit der Checksum kippt? könnte das nicht die datenintegrität gefähren?

Grüße

Also an sich werden Checksummen mit in den Blöcken gespeichert. Und zwar für jede Platte separat (raidz). Dadurch kann man dann einen Scrub machen und Fehler finden. Natürlich werden bestimmt auch Checksummen im RAM gehalten, bei den Details muss ich passen. Den Fall von Memorycorruption sollte man aber trotzdem früher oder später merken, schließlich ist das gesamte OS betroffen. (Kernelpanics, etc.)

Datenkorruption? ja, kann ohne ECC passieren. You get what you pay for.

ZFS schützt nicht vor Datenfehlern, die innerhalb des RAM durch sogenannte bit flips entstehen. Das Hashing von Dateiblöcken schützt deine Daten von Beginn des Schreibens der Daten auf den Datenträger bis Ende des Lesens der Daten in den Hauptspeicher.

Der Betriebssystemkernel berechnet die Hashes der Blöcke mit der CPU. Daher befinden sich die Hashes auch eine gewisse Zeit im Arbeitsspeicher deines Rechners und sind somit auch der Möglichkeit von Bitflips ausgesetzt. Vermutlich werden die Hashes auch recht lange im Arbeitsspeicher gehalten – ZFS hat einen recht großzügigen In-Memory-Cache (ARC), gut möglich, das bei dem auch die Hashes vorgehalten werden – ich bin mir aber nicht sicher.

Ohne ECC sollte man keinen (Heim-)Server betreiben. Bitfehler sind nicht so selten, wie man glaubt: http://lambda-diode.com/opinion/ecc-memory und http://lambda-diode.com/opinion/ecc-memory-2.

Was Hansen-Pansen sagt.

gibt es ne Übersicht welche haswell mainboards FreeBSD kompatibel sind? sollte man beim hardware kauf auf etwas spezielles achten? treiberprobleme mit onboard NICs oder so?

Mir ist keine derartige Liste bekannt. Aber das Board, das ich genommen habe ist auch nicht sehr fancy…

Kannst du was zum Stromverbrauch sagen ?

Keine konkreten Zahlen, nur soviel: der Stromverbrauch der Festplatten ist der wesentliche Faktor. Alles andere fällt nicht so sehr ins Gewicht.

Der Teil mit der Avahi-Config ist übrigens gar nicht notwendig. Netatalk registriert seine Services automatisch per D-Bus in Avahi. Das gleiche gilt übrigens auch wenn man mDNSResponder nimmt (nur, dass es dann über dessen API und nicht über D-Bus läuft).

Übrigens kommt Avahi bei mir auf FreeBSD mit IPv6-Adressen nicht klar. Es versucht die Adresse samt Interface-Identifier zu annoncieren, stört sich an dem ungültigen Adressformat und ignoriert die Adresse. Im Syslog findet sich eine entsprechende Meldung und die Clients sehen nur die IPv4-Adresse (ich bin mir nicht mehr sicher ob der Fehler nur die Link-Local-Adresse betrifft oder auch „normale“ IPv6-Adressen).

Fazit: mDNSResponder gewinnt. Es holt weniger Abhängigkeiten an Board und kommt mit IPv6-Adressen klar.

Aus irgendeinem Grund habe ich ohne die Config keine Connection hinbekommen. Vielleicht ist die Zeit für Avahi tatsächlich abgelaufen…

Hallo Roddi,

sehr schöne Anleitung. Danke!!!

Ich überlege auch, ob ich auf ein Eigenbau-NAS umsattele. Derzeit hab ich eine Diskstation von Synology laufen. Da stört mich aber, dass ich nicht so richtig mitbekomme, was „unter der Haube“ passiert.

Eine andere Frage, die mich schon lange beschäftigt:

Ich habe ebenfalls vor, daheim hinterm DSL einen eigenen Web- und IMAP-Server zu betreiben (angeregt durch eure Ausführungen in der Freakshow).

Ist es in deinen Augen sinnvoll, das auf der gleichen Hardware zu betreiben?

Auf der einen Seite wäre es praktisch, wenn nur eine Kiste daheim rumsteht.

Auf der anderen Seite halten dann aber Web- und IMAP-Server durch ihre höhere Aktivität die Platten wieder davon ab, ins Standby zu fahren (was sie normalerweise tun, wenn man nicht aufs NAS zugreift).

Oder kann man das mit ner cleveren ZFS-Konfiguration evtl. umgehen (z.B. 2 verschiedene Pools: Web/Mail gemirrort auf SSDs und den „NAS-Teil“ in nem separaten zraid)?

Außerdem darf die „NAS-Komponente“ mit den allerprivatesten Daten drauf unter keinen Umständen durch einen löchrigen IMAP-Server in Gefahr geraten. Ist man da z.B. mit BSD-jails schon auf der sicheren Seite?

Sind halt so Safety-/Security-Abwägungen.

Würde mich freuen, wenn du deine Sicht dazu mal teilen könntest.

Vielleicht könnt ihr diese Fragen ja auch in der Freakshow nochmal aufgreifen.

Vielen Dank und viele Grüße

ron

Also ich denke Du hast schon die richtigen „Problemzonen“ ausgemacht. Ich kann da nicht viel mehr zu sagen außer vielleicht, dass das die Hardware kaum ins Schwitzen bringt.

Das Problem mit den Atom Boards und dem nicht ausreichenden Speicher sollte gelöste sein :), z.B.

http://www.supermicro.nl/products/motherboard/Atom/X10/A1SAi-2750F.cfm

OK, 64 GB (4*16) gibts noch nicht wirklich, aber 32 GB sind kein Problem… Bin gerade am Teile für meinen Server zusammen zu suchen.

Ja, spannendes Board. Nur die SATA2-Ports sind ein Wermutstropfen.

@Roddi: Dem kann abgeholfen werden:

http://www.asrockrack.com/general/productdetail.asp?Model=C2550D4I

und der größere Bruder:

http://www.asrockrack.com/general/productdetail.asp?Model=C2750D4I

Beide mit FreeBSD unterstüzung.

Hallo, Roddi

Vielen Dank für die schöne Übersicht!

Eine Frage, welches script benutzt du denn zur Verwaltung der ZFS snapshots?

gruß

johannes

Bis jetzt keins. Über sachdienliche Hinweise würde ich mich allerdings freuen!

Also ich habe mir heute einmal das zfs-snapshot-mgmt script aus den ports (/sysutils) näher angesehen. Das schöne daran ist, dass man die Parameter der Snapshots und wann sie zu löschen sind übersichtlich in einer .conf festlegen kann. Dann startet man das Script nur noch per cronjob und fertig.

Nachteil war, dass das aktuelle zfs-snapshot-mgmt auf meinem freebsd10 nicht läuft.

Andere Scripte wie zfsnap sind in der Konfiguration viel aufwändiger. Daher wollte ich mal in die Runde fragen, was sich für freebsd10 am ehesten eignet. Sonst probier ich mal weiter und geb dann ne Rückmeldung.

Denn snapshots automatisiert wie es in FreeNAS möglich ist, wär schon gut.

btw – hab mir übers we auch mal die aktuelle nightly built von FreeNAS zu Gemüte geführt (die stable läuft nicht gescheit). Und ich muss sagen, dass es zwar im Ansatz schon ganz gut ist. Aber grundsätzlich läuft es noch viel zu unstabil. Und ehrlich gesagt ist mir die Konfiguration über die Konsole wesentlich übersichtlicher und angenehmer.

Außerdem kann ich in FreeNAS deutlich weniger selbst konfigurieren. zB. kann ich nicht einmal bestimmen, ob ich meine geli layer mit PW und mit PW&keyfile anlegen will. Man ist zum keyfile gezwungen – kann dies jedoch auch nicht in seiner Größe etc beeinflussen.

Und was mir mit Schrecken aufgefallen ist – die root-Konsole ist auf dem freenas einfach ungeschützt offen und man kann sie nicht mal passwort-schützen. Sprich man muss nur ein keyboard an die freenas Büxe stecken und schon ist man root.

Da war ich aber ganz schnell wieder beim guten alten FreeBSD – alles schön manuell auf der Konsole genau wie man es braucht.

PS:

Ich hab mir das Supermicro A1SAi-2750F neu zugelegt, welches mein altgedientes X7SPA-HF-D525 ersetzt. Dazu kann ich eine klare Kaufempfehlung aussprechen!

Läuft problemlos mit FreeBSD 10. Selbst die USB3 Anschlüsse werden auf Anhieb ohne Zutun von FreeBSD erkannt (FreeNAS hat die USB3er nicht akzeptiert).

Und ich habe über GBIT Ethernet über AFP auf ein Mavericks MBP einen Durchsatz von ca. 100 MB/s lesend und schreibend. Auf einem AES 256bit geli mit ZFS, lz4 (ohne deduplication).

Samba41 läuft übrigens bedeutend langsamer (ca 1/3 langsamer). Soviel zu der Samba Zukunft in OS X.

Jedenfalls eine klare Empfehlung für das Bord mit FreeBSD und ZFS!

Mein altes Supermicro ohne AES-ni bekam kaum 20 MB/s durch die Leitung.

Ja, Deine FreeNAS experience deckt sich in etwa meiner.

Also ich habe jetzt schon eine Reihe scripts durchgesehen zum automatisierten Snapshotting von ZFS und ich bin bei zfsnap hängen geblieben. Das scheint mir die simpelste und am leichtesten zu administrierende Lösung zu sein.

http://www.zfsnap.org/

http://www.zfsnap.org/zfsnap_manpage.html

Als preiswerte Hardwareplattform bietet sich der Dell Poweredge T20 an. Da gibts einen mittelmäßig potenten Prozessor und 4GB ECC-Ram in einem Gehäuse mit reichlich Platz für 200 EUR.

Wozu legt der FreeBSD Installer eigentlich sooo viele Volumes an? Damit meine ich nicht die offensichtlichen – sondern speziell zroot/ROOT und zroot/ROOT/default – wozu sind die gut?

Gute Frage! Weiß ich leider auch keine Antwort drauf. Meine Vermutung: Snapshots und Rollbackmöglichkeiten.

Ein kleines Gedankenspiel:

Wie würde es sich auf die Performance auswirken wenn man an die beiden USB3 Ports jeweils z.B. mit einem Laufwerksgehäuse 5 weitere Platten anhängen würde? ( https://www.alternate.de/Sharkoon/5-Bay-RAID-Box-Laufwerksgeh%C3%A4use/html/product/786290? )

Kann man den 5 Gbit Flaschenhals durch eine Cache SSD verkleinern oder beseitigen?

Grüße

Immanuel

ich denke mal, das kommt sehr auf dein Nutzungsprofil an. Ich würde vermuten, dass das was bei vielen kleinen Dateien bringt, während Videoschnitt eher das Falsche ist.

Läuft das ganze zuverlässig für TimeMachine-Backups? Ich habe derzeit einen Raspberry Pi mit Raspbian und Netatalk laufen. Leider werden die Backups (über Wlan) regelmäßig zertört. Als ich noch den AirPort Extreme mit USB-Platte am laufen hatte trat das Problem nie auf. Meine letzte Idee ist, den Raspberry mal unter FreeBSD laufen zu lassen. Wenn das nicht hilft muss ich den AirPort wieder in Betrieb nehmen.

Ab und zu geht das TM Backup kaputt. Ist wahrscheinlich ein netatalk Problem.

Danke für den Hinweis. Laut eines Users soll es wohl reproduzierbar sein, wenn man bei einem Backup über Wlan das Notebook ausschaltet bevor das Backup beendet ist. Ich werde das ganze mal unter FreeBSD ausprobieren.

Dennoch werde ich dann wohl mein Airport wieder aktivieren. Kaputte Backups sind unbefriedigend.